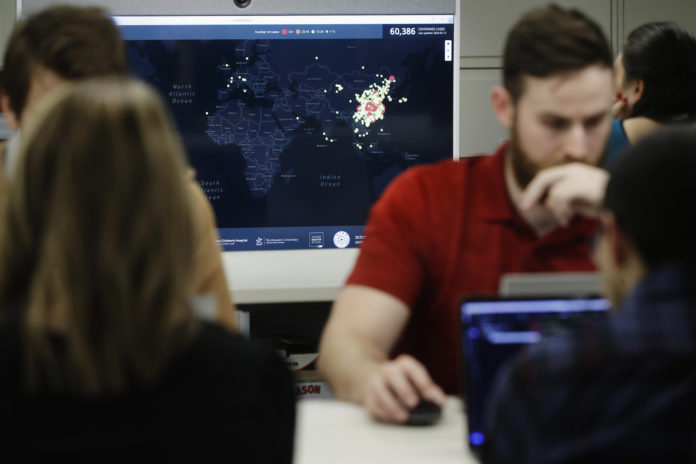

NEW YORK – L’intelligenza artificiale (AI) è divenuta un vero e proprio rischio per l’intera umanità. Essa riesce a manipolare tutti i nostri dati sensibili entrando dentro ad ognuno di noi e scavando anche nella psiche. Può identificare il volto di una persona tra la gente, oltre a scavare nelle emozioni o a classificare un soggetto in base a caratteristiche personalissime. Addirittura alcuni sistemi AI, agendo nel controllo delle emozioni, possono manipolare l’aspetto comportamentale di bambini, anziani o di altri consumatori, agendo sulle loro vulnerabilità cognitive, indirizzandoli così verso scelte commerciali non proprio desiderate. Inoltre questi tipi complessi di sistemi automatizzati sono spesso opachi e pertanto difficili da contestare.

I rischi

L’AI va dalla violazione della privacy alla discriminazione, dalla manipolazione mentale al rischio di danni fisici, psicologici o economici. Addirittura pare che siano in grado di identificare l’orientamento sessuale o anche la propensione al crimine a partire da caratteristiche facciali. Un progetto griffato Cina ha dato la possibilità ad alcuni algoritmi di poter identificare a livello emozionale un qualsiasi soggetto. Un progetto portato avanti in Estremo Oriente proprio sul riconoscimento emozionale della minoranza degli Uiguri, obbligati a testare l’algoritmo sottoponendosi a test forzati. Alcuni di questi algoritmi riescono a predire le capacità e l’affidabilità dei candidati per una posizione lavorativa. Il loro lavoro si basa su apparentemente normali video-interviste. Vi sono anche sistemi AI già utilizzati per le auto a guida autonoma, per le diagnosi mediche, per cani poliziotto robotici, oltre che per le armi “intelligenti”.

Le regole

Grazie a questi nuovi algoritmi, in Cina si riesce anche a classificare i cittadini in base a quanto rispettano le regole e a quanto mostrano obbedienza verso il partito. Ma non solo: anche per quanto concerne la discriminazione sul luogo di lavoro in base al sesso o all’orientamento sessuale o a danno di determinate minoranze sociali in contesti di polizia predittiva. Intanto sia l’Unione Europea che gli Stati Uniti si stanno avviando verso una necessaria quanto tempestiva regolamentazione delle applicazioni AI ad alto rischio, anche se con approcci diversi. La Commissione europea ha infatti già pubblicato una ‘Nuova proposta di ‘regolamento dell’intelligenza artificiale’ che dovrà essere discussa e approvata dal Consiglio e dal Parlamento Europeo.

La proposta

La proposta prevede “regole, proporzionali al livello di rischio, per prodotti e servizi basati sull’AI. Pur non prevedendo nessun nuovo diritto individuale per i consumatori/cittadini, il regolamento propone ambiziosi obiettivi di correttezza, sicurezza e trasparenza per le applicazioni AI”. Un quadro che si basa su diversi livelli di rischio: “alcuni sistemi di AI sono considerati a rischio intollerabile e sono pertanto proibiti” come nel caso delle pratiche online di manipolazione cognitiva che causano danni fisici o psicologici o sfruttano la vulnerabilità dovuta all’età o alla disabilità. Vanno anche aboliti i sistemi di valutazione sociale dei cittadini. Così come altri tipi di sistemi AI considerati ad alto rischio, ivi compreso “il riconoscimento facciale, o l’AI usata in infrastrutture critiche, in contesti di educazione, valutazione dei lavoratori, emergenza, assistenza sociale, valutazione del credito, o l’AI usata da parte delle forze dell’ordine, della polizia di frontiera e dei tribunali”.